2021 年 12 月 1 日

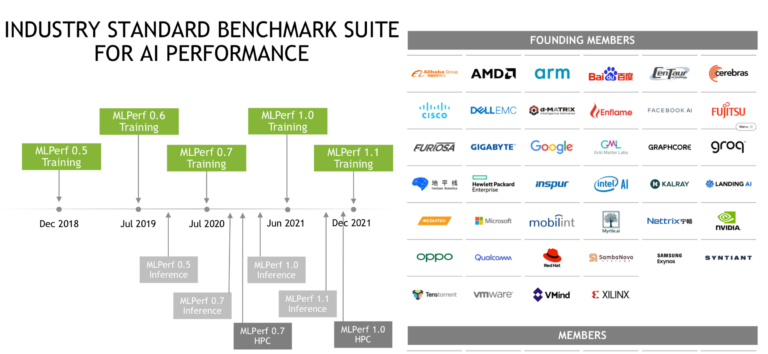

MLCommons 今天发布了第五轮 MLPerf 训练基准测试结果,Nvidia GPU 再次占据主导地位。也就是说,其他一些 AI 加速器公司也参与了其中,其中之一是 Graphcore,甚至举行了单独的媒体/分析师简报会,吹捧其 MLPerf 性能并声称其基于 IPU 的系统速度更快,并提供更好的性价比比类似大小的基于 Nvidia A100 的系统。同样值得注意的是,Microsoft Azure 在 MLPerf 训练练习中首次亮相,具有 Nvidia 加速的实例和令人印象深刻的性能。

由于提交的许多不同的系统配置,理解 MLPerf 结果从来都不是一件容易的事。例如,将使用多达 2,000 个 A100 的 Azure 部署与具有两个 CPU 和四个 GPU 的戴尔服务器的性能进行比较,这本身并不是特别有用。两者都可能非常适合所需的任务。我们的想法是根据您的需要查看八个训练工作负载的特定结果和配置。训练到预定质量的时间是品质因数。(结果链接)

MLCommons 报告说,最新一轮的基准测试收到了“14 个组织的提交,并发布了超过 185 个针对从边缘设备到数据中心服务器的机器学习系统的同行评审结果”。这与 6 月份的 13 个组织(培训 v1.0)大致持平,与提交的 650 个结果相比有相当大的下降。本轮提交者包括:Azure、百度、戴尔、富士通、技嘉、谷歌、Graphcore、Habana Labs、HPE、浪潮、联想、Nvidia、三星和超微。

从广义上讲,MLPerf 似乎正在稳固其作为机器学习(训练、推理和 HPC 工作负载)的基准的地位。考虑一下今天博客中Habana Labs(英特尔所有)的支持声明:

“MLPerf 社区旨在设计公平且有用的基准,为机器学习解决方案提供“一致的准确性、速度和效率测量”。为此,来自学术界、研究实验室和行业的 AI 领导者决定了一套基准和一套明确的严格规则,以确保在所有供应商之间进行公平比较。随着机器学习的发展,MLPerf 也在不断发展,从而不断扩展和更新其基准范围,并完善提交规则。在 Habana,我们发现 MLPerf 基准测试是人工智能行业唯一可靠的基准测试,因为它有一套明确的规则,可以对端到端任务进行公平比较。此外,MLPerf 提交经历了为期一个月的同行评审过程,这进一步验证了报告的结果。”

同样重要的是 MLPerf 的缓慢扩张,而不仅仅是 Nvidia 加速器的展示——Nvidia 和 Graphcore 之间的较量就是一个很好的例子(更多内容见下文)。目前,根据人们如何划分数字,英伟达仍然是王者。

主要依靠大型系统——Nvidia 超级计算机 Selene,在Top500 中排名第六,以及 Microsoft Azure ND A100 v4 系列实例的大规模部署——Nvidia 获得了最高荣誉。Nvidia GPU 性能在所有 MLPerf 练习中都无可争议地令人印象深刻(单击下面显示的图表可放大)。此外,正如 Nvidia 的数据中心计算产品管理高级总监 Paresh Kharya 所指出的那样,Nvidia 再次成为在封闭的“苹果对苹果”部门中运行所有八种工作负载的唯一提交者。他尖锐地指出,谷歌 (TPU) 没有在封闭部门提交,而且 Habana (英特尔) 只提交了两个工作负载(BERT 和 ResNet 50)。

MLPerf 有两个部门:“封闭部门旨在比较硬件平台或软件框架‘苹果对苹果’,并且需要使用与参考实现相同的模型和优化器。Open 部门旨在培养更快的模型和优化器,并允许任何可以达到目标质量的机器学习方法。” – MLCommons。

在发布 MLPerf 结果时出现了一个有趣的模式——至少在训练和推理方面是这样。MLCommons 与在场的大多数参与者的代表进行了一般性简报。这是一个友好的事情,有礼貌的评论。然后,个人提交者可能 - 在这种情况下是 Nvidia 和 Graphcore - 举行更多直接竞争的简报会,相对于竞争对手吹捧他们的产品。

在 Nvidia 的简报中竞争激烈,因为 Kharya 宣布“Nvidia AI(广义上)比 [Google 的] TPU(从早期的 v1.0 运行)快 5 倍,比 Graphcore 快 30 倍,比 Habana 快 50 倍。”

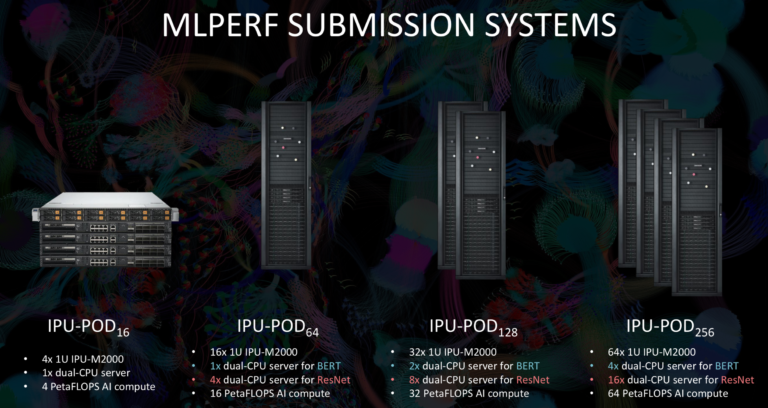

毫无疑问,Graphcore 有不同的看法。在最新一轮中,Graphcore 提交了来自四个系统的结果,所有系统都利用了其IPU(智能处理单元),该公司称其为有史以来“最复杂的处理器”(594 亿个晶体管和 900MB 的高速 SRAM)。

在单独的预简报中,Graphcore 试图强调其 MLPerf 性能,并广泛介绍 Graphcore 的进展。首席软件架构师 David Lacey 将软件进步列为 Graphcore 提高性能的最重要驱动因素。Lacey 将矛头指向 Nvidia,认为 Graphcore 的性能优于类似大小的基于 A100 的系统,在其系统中提供了卓越的 CPU 与加速器的比率,不仅提高了可扩展性,而且还降低了系统成本。他说,该架构也很灵活,允许用户选择合适的 CPU 加速器比率。

“您可以在 BERT 中看到,我们有一个用于 32 个加速器的主机处理器,而在 ResNet 上,我们有一个 [CPU] 用于八个加速器。在 ResNet 中需要比 BERT 更多的主机 CPU 的原因是因为 ResNet 正在处理图像,而 CPU 执行一些图像解压缩。无论哪种方式,比率都较小。我认为更重要的是,那里有效率,我们有一个分解的系统,我们可以灵活地改变这个比例,”莱西说。

Habana 还在一份新闻稿中吹捧了它的表现,并提供了私人简报。“Habana 在基于 Gaudi 的集群上提交了语言 (BERT) 和视觉 (ResNet-50) 基准测试结果,并展示了 Gaudi 处理器的近线性可扩展性,使用相同的 Gaudi 将 BERT 的训练时间提高了 2 倍以上处理器与我们上一轮的结果相比。此外,高迪在 ResNet-50 上的训练时间提高了 10%,”Habana 报道。撇开争论的技术优点不谈,不同的 AI 芯片和系统制造商正在使用 MLPerf 练习来展示他们的产品并与 Nvidia 较量这一事实通常对 MLPerf 来说可能是一个好兆头,这表明它正在朝着更真实的多 AI 技术发展展示比较性能。

Hyperion Research 的分析师 Steve Conway指出:“MLPerf 是早期人工智能时代为数不多的可用基准之一,并且很受欢迎,尽管在最初的强劲增长之后,新的采用已经趋于平稳。如今,英伟达在 AI 加速方面占据主导地位,但毫不奇怪,这个高增长的市场现在已经吸引了 AMD 和英特尔的强大竞争对手,以及 Graphcore、Cerebras 等创新型新兴公司。建议希望绕过双曲线声明和不可信比较的用户通过直接询问其他用户的体验来补充标准的基准测试结果。”

该MLPerf结果最好直接探索牢记您的特殊要求。MLPerf 再次允许参与者提交关于他们的系统和性能的简短陈述。他们的范围从信息到主要是营销。它们包含在下面(v. 轻微编辑)。

浪潮电子信息产业有限公司是领先的数据中心基础设施、云计算和人工智能解决方案提供商,位列全球服务器厂商前三。通过工程和创新,浪潮提供尖端的计算硬件设计和广泛的产品系列,以应对开放计算、云数据中心、人工智能和深度学习等重要技术领域。

在 MLCommons TrainingV1.1 中,浪潮在两个系统上进行了提交:NF5488A5 和 NF5688M6。NF5488A5是浪潮旗舰服务器,针对大规模HPC和AI计算的极致设计。它包含 8 个带液冷的 A100-500W GPU。NF5488A5系统具有耐高温能力,工作温度可达40℃。4U设计,可广泛部署于数据中心,大大降低成本,提高运营效率。NF5688M6 基于第三代英特尔至强可扩展处理器,性能较上一代提升 46%,可支持 8 个带风冷的 A100 500W GPU。它可容纳 10 多个 PCIe Gen4 设备,并带来 GPU、NVMe 存储和 NVIDIA Mellanox InfiniBand 网络的 1:1:1 平衡比例。

在封闭划分中,Bert、SSD和DLRM的单节点性能比浪潮在Training v1.0中获得的最佳性能提升了16.03%、4.0%和10.99%。此外,浪潮首次提交了Mask R-CNN、Minigo、RNN-T和3D UNET的结果,在这些工作负载上都取得了良好的性能。

【公司名称】四川旭辉星创科技有限公司

【代理级别】成都浪潮Inspur服务器总代理

【销售经理】李经理

【联系方式】座机:028-85596747 手机:13540160369

【公司地址】成都市人民南路4段 桐梓林 商鼎国际2号楼1单元1913

请用微信扫描二维码