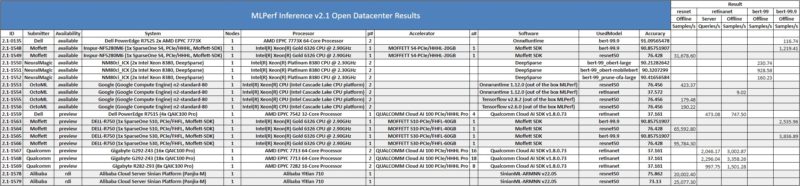

虽然 MLPerf 训练主要是 NVIDIA 的基准,但 MLPperf 推理更有趣。这次的 MLPerf Inference v2.1 结果包括多项新技术,包括英特尔为下一代 AI 推理加速器设定了底线,以及来自 NVIDIA、Biren、Moffett 等公司的新加速器选项。

MLPerf Inference v2.1 结果预览下一代 AI 技术

我们将重点关注 MLPerf Inference v2.1 开放数据中心和封闭数据中心结果。Open 类别中有许多有趣的解决方案。

在最新的开放数据中心类别中,有阿里巴巴亿天710芯片。这些是我们之前介绍的新 Arm CPU。在开放类别中,这些不需要做相同的数学运算,因此无法将它们与封闭类别进行比较,但这仍然是一个有趣的结果。

另一个有趣的是 Moffett S4、S10 和 S30 PCIe 加速器。再来看看S4:

与许多其他解决方案一样,Moffett 在其设计中利用了稀疏性,因此这可能就是为什么它们属于开放类别而不是封闭类别的原因,因为在开放类别中如何利用它有更多的余地。

谈到封闭类别,我们看到了一些不错的结果,但也有一些有趣的结果。

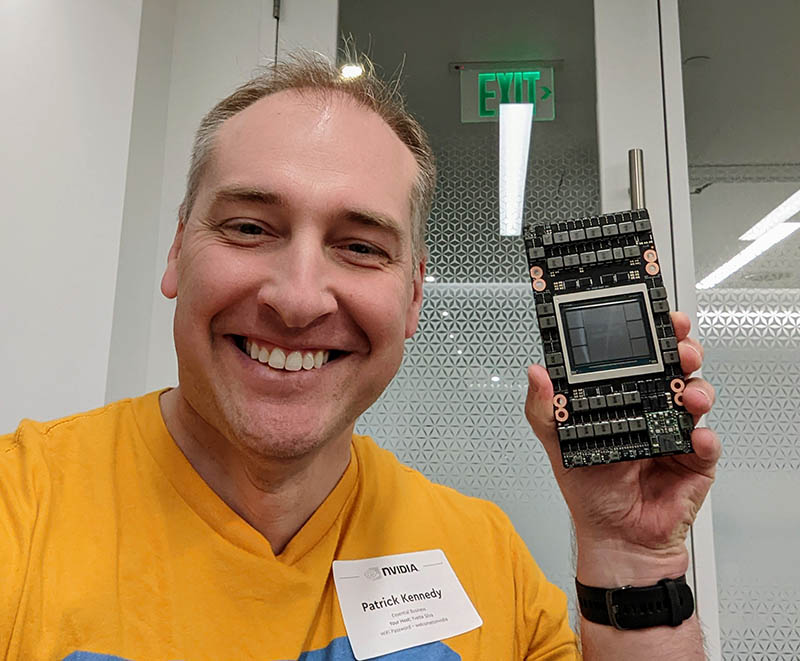

NVIDIA 展示了新的 H100。随着时间的推移,NVIDIA 的结果往往会变得更好,因此使用 Xeon Silver 4314 和 EPYC 7252 的新结果在这一点上看起来不错。

有趣的结果之一是 Sapeon X220。这些已安装在 Supermicro 服务器上,是这次将使用 MLPerf Inference 测试的一些老一代技术。尽管如此,看到这个硬件还是很有趣的。

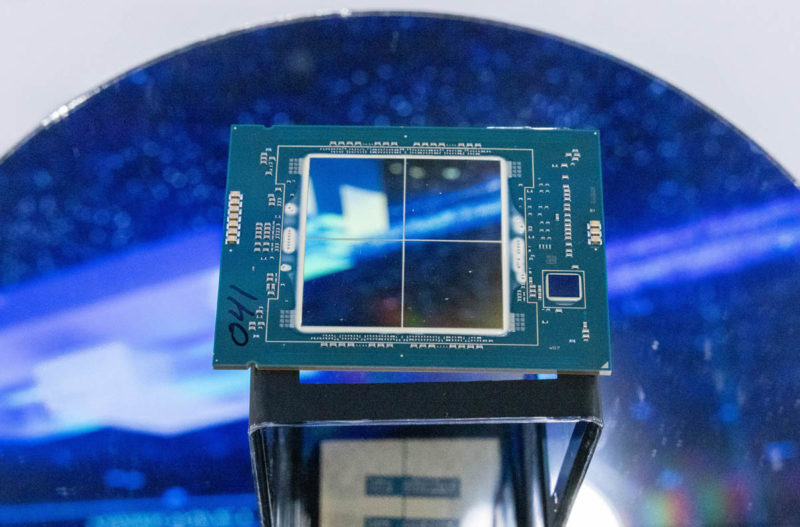

Biren BR100“BR104-300W PCIe”在浪潮NF5468M6服务器中出现。8x PCIe 解决方案看起来好像最终会介于 NVIDIA A100 和 H100 之间,这对于第一个 GPU 架构加速器来说是相当惊人的。这让人有点好奇,Biren 是如何与 AMD 和 Intel 等公司相比如此迅速地做到这一点的。该公司只提交了 ResNet 和 BERT 99.9 结果,但它们肯定是有希望的。

英特尔为下一代推理奠定了基础。Sapphire Rapids 2-socket 结果使用了 PyTorch,但它也显示了与 NVIDIA A2 或更高版本的推理性能,具体取决于基准。英特尔并未提交所有测试,但暗示随着下一代加速的发展,为了获得一些推理能力而部署具有单个 <60W PCIe 推理加速器的 1U 服务器的旧模式可能会被淘汰。虽然可以将 PCIe 和其他外形尺寸扩展到每个系统的更高性能,但在每个 CPU 中实现推理加速是一件大事。这就是我们在 2022-2023 年将 AMD Arm 和 Intel 服务器 CPU 称为更多核心更好的部分原因。

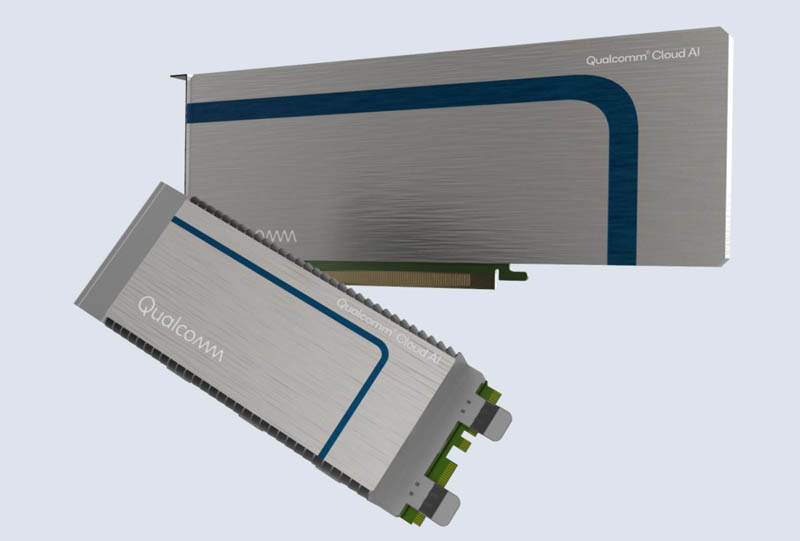

高通再次推出 Cloud AI 100。高通表示需求量很大。从我们所看到的情况来看,服务器供应商希望他们的服务器通过 NVIDIA 进行审查,其中一些使用 AMD GPU,但我们尚未收到测试基于 Qualcomm 的解决方案的请求。通常我们看到的是市场动能的指标。我们看到罗马一代对 EPYC 产生了浓厚的兴趣,这就是一个例子。

我们想要指出的一个荣誉奖是 NVIDIA Jetson AGX Orin,尤其是在封闭边缘类别中。

这是我们几个月前看到的,但在这一代中,它的每瓦性能提高了 50%。

这是 NVIDIA 软件随着时间的推移变得更好的一个例子。

最后的话

MLPerf 推理中肯定有很多有趣的硬件。这可能是训练方面不那么有趣,但推理方面越来越有趣的情况。理论上,推理市场最终会比训练市场大得多,所以这也许是有道理的。如果您确实想深入研究结果,MLCommons 会在线发布其完整结果。

【公司名称】四川旭辉星创科技有限公司

【代理级别】成都浪潮Inspur服务器总代理

【销售经理】李经理

【联系方式】座机:028-85596747 手机:13540160369

【公司地址】成都市人民南路4段 桐梓林 商鼎国际2号楼1单元1913

请用微信扫描二维码